IA et plateformes locales

L’évolution rapide de l’intelligence artificielle (IA) en 2025 a alimenté un intérêt croissant pour l’exécution de modèles IA localement sur des ordinateurs personnels. Cette tendance est motivée par le besoin d’une confidentialité renforcée, d’une latence réduite et d’une rentabilité supérieure aux solutions basées sur le cloud. Les plateformes IA au format compact, telles que les ordinateurs de bureau et les mini-PC, sont idéales pour les développeurs, chercheurs, étudiants et petites entreprises souhaitant prototyper ou déployer des modèles IA comme les grands modèles de langage (LLM) ou des outils de génération d’images, sans dépendre d’une infrastructure lourde. Les avancées en optimisation des modèles (par ex., quantification) et les microservices comme NVIDIA NIM permettent d’exécuter des charges de travail IA complexes sur du matériel compact.

Cet article offre un aperçu complet des plateformes IA au format compact et des GPU disponibles en 2025, en se concentrant sur les offres de NVIDIA, les alternatives concurrentes et les recommandations pour divers cas d’usage.

Pourquoi l’IA en local ?

Le calcul IA local offre plusieurs avantages :

- Confidentialité : Données sensibles conservées sur site, évitant les vulnérabilités du cloud.

- Faible latence : Traitement plus rapide sans délais réseau.

- Économies de coûts : Suppression des abonnements cloud récurrents.

- Accessibilité : Modèles et frameworks optimisés permettent une IA puissante sur des appareils plus petits.

Ces avantages rendent les plateformes compactes attractives pour un large éventail d’utilisateurs, des amateurs expérimentant l’IA générative aux professionnels formant des modèles complexes.

Les plateformes IA compactes de NVIDIA

NVIDIA continue de dominer le marché du matériel IA avec des plateformes compactes innovantes conçues pour le calcul local. Voici les principales offres disponibles en octobre 2025.

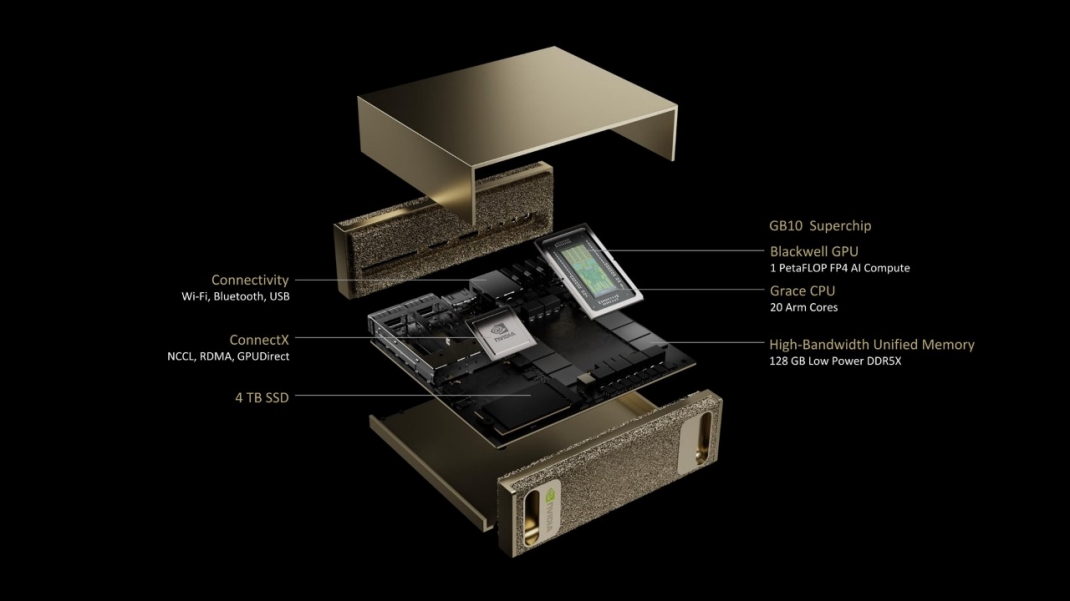

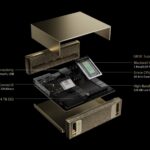

DGX Spark (Project DIGITS)

Annoncé à GTC 2025, le DGX Spark (anciennement Project DIGITS) est présenté comme le plus petit superordinateur IA au monde. Il cible les chercheurs, data scientists, développeurs de robotique et étudiants.

Spécifications

| Caractéristique | Détails |

|---|---|

| Composant principal | NVIDIA GB10 Grace Blackwell Superchip (CPU : 20 cœurs, 10 Cortex X-925 + 10 Cortex-A725 ; GPU : Blackwell) |

| Performance IA | Jusqu’à 1 petaflop (1 000 billions d’opérations par seconde) pour le fine-tuning et l’inférence |

| Mémoire | 128 GB unifiée, jusqu’à 4 TB NVMe |

| Interconnexion | NVLink-C2C (5x bande passante PCIe Gen 5) |

| Modèles supportés | NVIDIA Cosmos Reason, GR00T N1 (modèle de fondation robotique) |

| Intégration | Plateforme IA complète NVIDIA, scalable vers DGX Cloud |

| Fabricants | ASUS, Dell, HP Inc., Lenovo |

| Prix | ~3 000 $ (confirmé via annonces officielles) |

Fonctionnalités

- Design compact : Taille comparable à un Mac Mini, idéal pour le bureau.

- Efficacité énergétique : Optimisé pour une faible consommation.

- Support logiciel : Compatible TensorFlow, PyTorch, Llama.cpp, NVIDIA NIM (ChatRTX, ComfyUI, etc.).

- Cas d’usage : Exécution de modèles IA génératifs jusqu’à 200 milliards de paramètres (LLM, Stable Diffusion).

Le DGX Spark révolutionne l’IA locale en offrant une puissance de superordinateur dans un format accessible.

DGX Station

Pour les utilisateurs nécessitant plus de puissance, la DGX Station est une solution de bureau haute performance pour les charges IA complexes.

Spécifications

| Caractéristique | Détails |

|---|---|

| Composant principal | GB300 Grace Blackwell Ultra Desktop Superchip |

| Performance IA | 20 petaflops (20 000 TOPS) |

| Mémoire | 784 GB |

| Cas d’usage | Entraînement et inférence de modèles IA à grande échelle |

Fonctionnalités

- Haute performance : Convient aux tâches IA professionnelles, y compris l’entraînement de grands modèles.

- Évolutivité : S’intègre à l’écosystème NVIDIA pour des transitions cloud fluides.

- Limites : Plus volumineux et coûteux que le DGX Spark.

Jetson Orin Nano

Le Jetson Orin Nano (successeur du TX2) est utilisé pour les tâches IA légères dans des configurations de bureau.

Spécifications

| Caractéristique | Détails |

|---|---|

| Performance | >40 TOPS |

| Taille | Module carte de crédit |

| Consommation | <15 W |

| Cas d’usage | IoT, robotique, drones |

GPU pour le calcul IA local

Pour les configurations personnalisées, les GPU sont essentiels. La série GeForce RTX 50 (architecture Blackwell) domine le marché.

NVIDIA GeForce RTX 5090

GPU phare grand public en 2025, offrant des performances inégalées pour l’IA.

Spécifications

| Caractéristique | Détails |

|---|---|

| Cœurs CUDA | 21 760 |

| Tensor Cores | 5e génération, 3 352 AI TOPS |

| Ray Tracing Cores | 4e génération, 318 TFLOPS |

| Mémoire | 32 GB GDDR7, interface 512-bit |

| Fréquence boost | 2,41 GHz |

| Consommation | 575 W |

| Prix | ~2 000 $ |

Fonctionnalités

- Performance IA : Supporte les grands LLM (LLaMA 70B) et génération d’images (Stable Diffusion XL).

- Technologies : DLSS 4 avec Multi Frame Generation, NVIDIA Reflex 2, ray tracing neuronal.

- Support logiciel : CUDA 12.5, TensorRT-LLM, NVIDIA Broadcast.

- Cas d’usage : Idéal pour chercheurs et développeurs exécutant des modèles complexes localement.

Autres GPU NVIDIA

- RTX 4090 : 24 GB GDDR6X, toujours excellente (~1 800 $).

- RTX 5080 : 16 GB GDDR7, équilibre performance/prix (~1 200 $).

- RTX 4060 Ti 16 GB : Option économique pour petits modèles (~500 $).

- RTX A6000 Ada : 48 GB pour usage professionnel (~6 000 $).

Concurrents et alternatives

AMD

- Radeon RX 8900 XTX (RDNA 4) :

- VRAM : 24 GB

- Logiciel : ROCm 6.2 (amélioré, mais < CUDA)

- Prix : ~1 100 $

- Limites : Support framework limité.

Intel

- Arc B580 :

- VRAM : 12 GB

- Logiciel : oneAPI, DirectML

- Prix : ~350 $

- Limites : Performances IA inférieures.

Apple

- M4 Pro/Max (Mac Studio) :

- Jusqu’à 128 GB RAM unifiée

- Optimisé via Metal Performance Shaders

- Avantages : Efficace pour Mistral 7B, LLaMA 13B.

- Limites : Non adapté aux charges lourdes.

Startups

- Groq : LPU pour inférence ultra-rapide (format carte PCIe).

- Cerebras : WSE-3 pour centres de données uniquement.

Choisir le bon matériel

Critères clés :

- VRAM :

- 8 GB : Petits modèles (Mistral 7B Q4)

- 16 GB : Modèles moyens (LLaMA 13B, SDXL)

- 24 GB+ : Grands modèles (LLaMA 70B, entraînement)

- Performance IA : Mesurée en TOPS (RTX 5090 : 3 352 TOPS)

- Budget : 300 $ (RTX 3060) → 10 000 $+ (DGX Station)

Configuration système recommandée :

- CPU : Intel Core i9-14900K ou AMD Ryzen 9 9950X

- RAM : 64 GB minimum (128 GB pour entraînement)

- Stockage : 2 TB NVMe SSD

- Alimentation : 1000W+ 80+ Platinum

Recommandations par cas d’usage

| Utilisateur | Matériel recommandé | Cas d’usage |

|---|---|---|

| Débutants | RTX 4060 Ti 16 GB (~500 $) | Mistral 7B, Stable Diffusion |

| Recherche | RTX 5090 ou DGX Spark | LLaMA 70B, Mixtral 8x22B |

| Professionnels | RTX A6000 Ada ou DGX Station | Entraînement, rendu 3D |

| Apple | Mac Studio M4 Max | Tâches légères |

Tendances 2025

- Dominance NVIDIA : CUDA 12.5, TensorRT-LLM 10.0, NIM microservices.

- Outils open-source : Ollama 0.3.0, Llama.cpp (quantification 2-bit).

- Efficacité énergétique : Blackwell offre 2x perf/watt vs Ada Lovelace.

- Nouveaux modèles : Llama 3.2 (1B-405B), Grok 3 optimisé localement.

Conclusion

En 2025, NVIDIA domine avec le DGX Spark (1 petaflop, 3 000 $) et la RTX 5090 (32 GB, 3 352 TOPS), offrant les meilleures solutions pour l’IA locale. Les concurrents progressent mais manquent d’écosystèmes complets. Pour tous les niveaux, NVIDIA reste le choix incontournable pour l’IA locale performante et accessible.